ぽんぽこちゃんのニセモノのニセポコに、Youtubeショート動画のショート リミックス機能を利用しご本人の声をかぶせてみる。

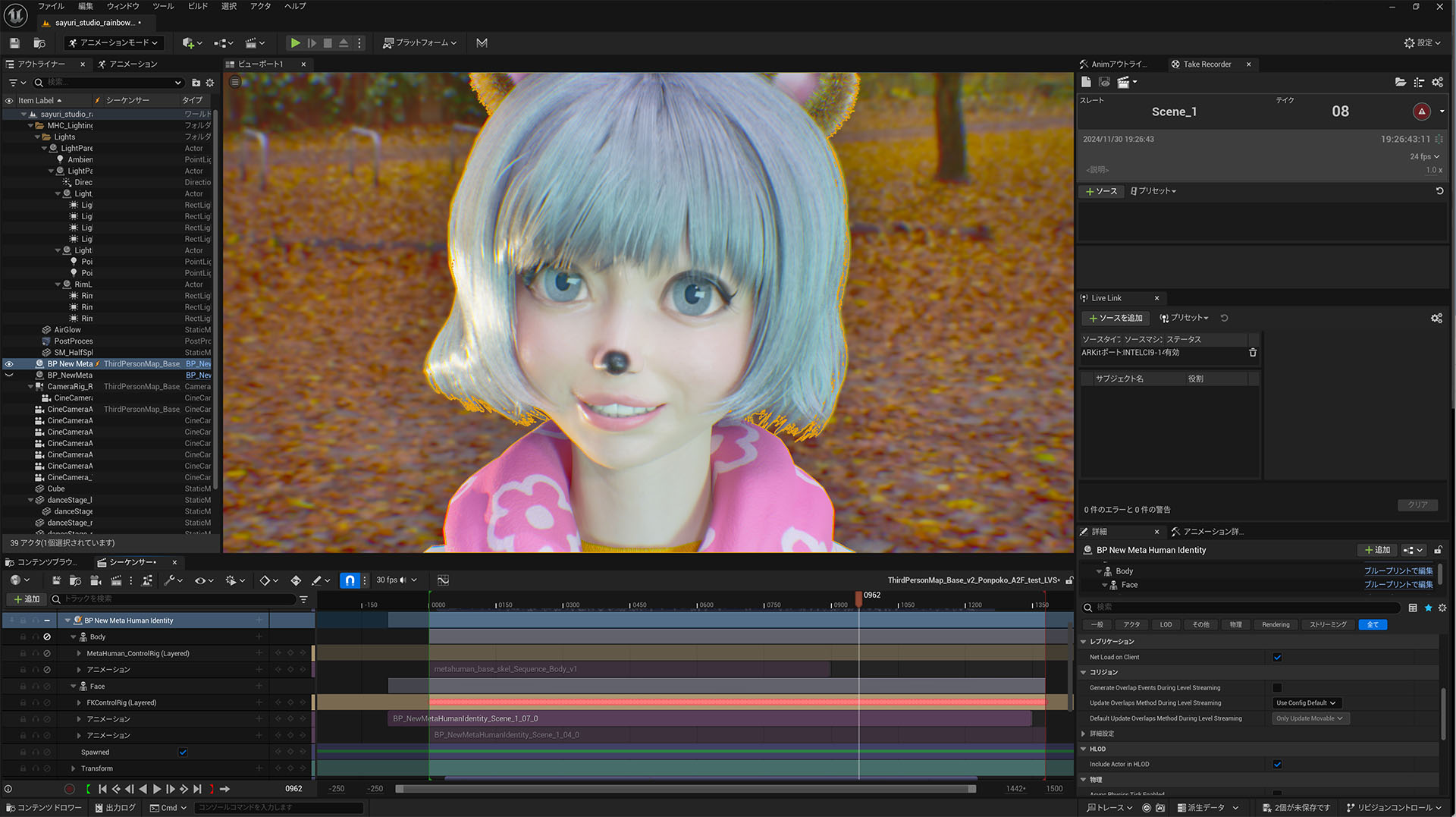

口パクは Audio2Face で音声から抽出処理、その他の動きは Live Link Face でモーキャプ処理をしたものを合成している。

日本語は4DキャプチャーによるフェイシャルのML(マシンラーニング)がおこなわれていない為にかなり悲しい状態。現状は マーク / Mark( v1 & v2 / 英語 )、 クレア / Claire( v1 / 中国語 ) の二種類で、かなり前から英語はあったが、待ちに待って追加されたのが中国語。・・・まぁ、世界の経済情勢的にいって当然といった感じかな。

2年待ってこの状態なのでNvidia的にはマルチランゲージに対応したデータセットを作る意思はないのかもしれない。以前にCG World誌でレビューを当方が執筆した際も「作っていただくのは自由です、やり方はお教えします」といったスタンスで、日本語を作りたければ ” とうぞ ” っといった感じだったのを記憶している。

学習させるのは設備(4Dキャプチャー)も用意しなくてはいけないし、それなりにお金のかかることなのでなかなか手が出せたものではない。

Nvidiaが協力し日本企業が作成、その後NvidiaがA2Fに実装し日本語プリセットとして無償提供・・・これが理想のシナリオかな。